Продвижение сайтов — это комплекс мероприятий, направленных на улучшение видимости ресурса в поисковых системах и увеличение его посещаемости. Одним из ключевых аспектов является SEO — поисковая оптимизация, которая включает в себя как внутренние, так и внешние факторы. Внутренняя оптимизация охватывает такие элементы, как структура сайта, мета-теги, контент и скорость загрузки страниц. Внешняя оптимизация предполагает создание качественных обратных ссылок и активное участие в отраслевых сообществах.

Раскрутка сайта требует внимательного анализа целевой аудитории и использования эффективных стратегий. Это может включать контент-маркетинг, где высококачественный контент привлекает пользователей и повышает доверие к сайту. Социальные сети также играют важную роль в продвижении, позволяя привлечь новых посетителей через вирусный контент и таргетированную рекламу.

Комплексный подход к SEO-раскрутке сайтов, включающий анализ ключевых слов, управление репутацией и постоянный аудит результатов, поможет вам достичь высоких позиций в поисковой выдаче и значительно увеличить поток клиентов. Успешная стратегия продвижения — залог роста и стабильности вашего онлайн-бизнеса.

Основной работой считается внутренняя оптимизация веб-сайта. Такие работы увеличивают возможность автоматического вывода сайта на первые позиции, а также однозначно растет интерес посетителей к вашему сайту.

Внутренняя оптимизация сайта состоит из следующих шагов:

- Анализ, определяющий характеристики сайта. Этот шаг позволяет выявить ошибки, допущенные веб-мастерами. Когда ваш сайт посещают поисковые системы, они делают вывод о качестве сайта. Если оптимизированный сайт содержит много недостатков, поисковая система делает выводы по каждому из них и сообщает системе, которая делает выводы о качестве сайта. Эти результаты в значительной степени повлияют на рейтинг вашего сайта;

- Исправление недостатков, выявленных на первом этапе;

- Составление списка слов и словосочетаний (семантическое ядро сайта), которые могут наиболее точно описать тематическую направленность. Наши специалисты не просто находят ключевые вопросы, предложенные системой подбора фраз, а делают это на основе реального человека, который является целевым покупателем;

- Анализ статистических ключевых слов, подбор страниц и разделов сайта;

- По заранее определенному семантическому ядру Мета-теги Ключевые слова и Описание, а также Заголовок в соответствии со стандартами выполняются;

- Скорректированы URL-страницы и навигация, что позволило адаптировать пункты меню и адреса под семантическое ядро сайта;

- Тексты оптимизированы. Процесс требует способности удовлетворить требования как поисковой системы, так и посетителей».

- Перелинковка выполняется, что позволяет распределить вес страниц вашего веб-сайта. Для большего эффекта внутренней оптимизации сайта мы разработаем специальную схему перелинковки специально для вашего сайта.

На внутреннюю оптимизацию приходится 99% всего SEO. сюда входит работа с кодом, работа с юзабилити и удовлетворение потребностей поисковых систем; По сути, охватить всю внутреннюю оптимизацию — это все равно, что охватить всю работу SEO-специалиста, что просто невозможно. Поэтому в этой статье мы даем обзор, в каких направлениях вообще стоит «копаться», чтобы: а) раскрутить сам сайт; или: б) оценить тщательность, с которой ваш сеошник выполняет SEO.

Итак, приступим к построению «внутреннего SEO».

SEO оптимизация сайта изнутри

Инструкция по сео оптимизации сайта:

Довести сайт до технического совершенства:

- Заполнить robots.txt и sitemap.xml,

- Настроить 404,

- Настроить 301 и 302 редиректы,

- Избавиться от дублированного контента, метатегов,

- Оптимизировать сео-изображения;

Наполнить сайт ключевыми словами:

- Поиск по ключевым словам (семантика),

- Создавать контент в соответствии с семантикой,

- Правильно заполнять SEO-теги (заголовок, h1-h6, описание, ключевые слова, сильные);

Сделайте сайт удобным для пользователей:

- Улучшить удобство использования

- Усилить деловые факторы;

Повысить CTR в результатах поиска:

- Внедрить разметку схемы от Schema.org,

- Использовать все возможности для повышения CTR;

Проверить веб-сайт по контрольному списку SEO-оптимизации веб-сайта.

Довести сайт до технического совершенства

Чтобы поисковая система добавила веб-сайт в ТОП-10, этот веб-сайт должен быть сначала включен в индекс ПС — поисковую базу данных, в которой хранятся все веб-страницы и документы, доступные для поисковых систем. А чтобы в индекс попадали страницы с контентом, а не технические, нужно правильно настроить сайт.

Контрольный список для технической оптимизации:

- robots.txt корректно заполнен на сайте;

- Sitemap.xml правильно заполнен на сайте;

- Несуществующие страницы возвращают ответ 404 Not found;

- Есть пользовательская страница 404;

- Количество страниц в индексах Яндекса и Google немного отличается;

- URL построены по принципу ЧПУ;

- Есть «хлебные крошки»;

- Уровень вложенности не выше 3;

- Нет дублированного контента, нет мета-тегов;

- Нет битых ссылок;

- Код сайта действителен;

- Изображения оптимизированы.

Заполните robots.txt и sitemap.xml.

Первым шагом на пути к техническому совершенствованию сайта является прямое указание поисковым системам, какие страницы следует и не следует индексировать. Эти команды определены в специальном файле robots.txt, расположенном в корне сайта.

Принцип заполнения robots.txt очень прост: мы задаем «правила поведения» (policies) для всех файлов для PS robots, и роботы придерживаются этих правил при изучении сайта и не «спотыкаются», когда индексируют.

Официальная помощь по заполнению robots.txt: от Яндекса и Google.

Совет. Теперь зайдите в файл robots.txt на своем сайте (https://www.your-site.ru/robots.txt) и проверьте, не закрыт ли он от ПС. Если вы видите

User-Agent: *

Disallow: /

Это значит, что ни одна поисковая система не увидит ваш сайт и вам срочно нужно сделать внутреннюю оптимизацию!

Еще один вспомогательный файл для связи с ПС-ботами — sitemap.xml. Это особенно важно для сайтов с большим количеством страниц. Потому что ПС-боты обходят страницу последовательно: зашел на страницу A, нашел ссылку на страницу B, зашел на C, нашел ссылку на D и так далее. При этом количество страниц, которые поисковая система просматривает в день на сайте, ограничено (краулинговый бюджет). Итак, если на сайте не менее 100 страниц, разбитых на несколько категорий, лучше дать поисковику возможность обойти сайт. Этот маршрут определен в карте сайта sitemap.xml. При наличии карты сайта добавление страниц в индекс будет происходить быстрее (и обновление при новом сканировании также будет быстрее).

Добавьте в карту сайта полный список страниц ресурсов и загрузите их в корневую папку типа robots.txt, чтобы адрес был таким: https://www.your-site.ru/sitemap.xml.

А чтобы не заполнять карту больше 100 страниц вручную, используйте специальные модули, автоматизирующие создание карты сайта, которые есть у популярных CMS. Подробнее о том, как создать XML-карту сайта, читайте в Справке Яндекса.

Как настроить 404 ошибку

Когда пользователь вводит URL-адрес в адресную строку браузера (например, https://your-site.ru/blog/), браузер обращается к серверу, на котором хранится эта страница, и получает в ответ код состояния. Два наиболее распространенных кода состояния — 200 OK и 404 Not Found: первый означает, что страница с запрошенным адресом действительно существует (и эта страница загружается); во-вторых, страница с запрошенным адресом не существует.

Если в адресной строке введен адрес, где нет страниц (например, https://your-site.ru/blok/), сервер в браузере должен ответить 404 Not Found и в окне браузера появится «заглушка» и сообщить пользователю, что его адрес необходимо исправить.

Вот что произойдет, если на веб-сайте не реализована функция интеллектуального ответа для несуществующих страниц:

- Посетив несуществующий сайт, пользователь Интернета попадает в тупик и покидает сайт;

- Если вы переходите на несуществующую страницу, сканер считает, что она существует (в конце концов, 200OK) и добавляет ее в индекс как дубликат.

Поисковые системы ненавидят дубликаты (см. раздел «Дублированный контент», «Удаление метатегов» ниже). Поэтому убедитесь, что вы настроили 404 для пустых страниц!

Распространенные CMS уже по умолчанию оснащены функцией грамотного ответа на несуществующие страницы, но это неправильно. Так что лучше проверьте: введите неправильный адрес в адресной строке, проверьте, появляется ли «страница 404», и проверьте код ответа (например, здесь: www.redirect-checker.org). Если что-то не так, исправьте это немедленно.

Настройте переадресацию 301 и 302.

Большая проблема для поисковых ботов — редиректы в теле страницы. В структуре - значит в адресах текста/меню/изображения и т.д., т.е. где-то в месте, с которым краулер сталкивается при просмотре страниц. Каждый раз, когда он сталкивается с редиректом во фреймворке, краулер как бы спотыкается (загружает для него первый URL, а потом вдруг перенаправляет на второй), и вы получаете какой-то негативный рейтинг. Потом посмотрим, где и как правильно использовать редиректы, чтобы не раздражать поисковых ботов.

Советы. Избегайте слишком длинных адресов и высокой вложенности, структура должна быть четкой и лаконичной, а приоритетные страницы не должны отстоять от главной страницы более чем на 3 клика. Иначе поисковые роботы не будут обходить большинство страниц, что приведет к низкой индексации сайта и потере трафика.

Если при оптимизации внутренних страниц вам пришлось изменить адрес (был непонятный site.ru/1/n1234, решили заменить на понятный site.ru/catalog/nazvanie-tovara-artikul-1234), то используйте 301-й обход. Затем для перенаправленных страниц, уже находящихся в результатах поиска, поисковая система проиндексирует новую страницу и заменит адрес в результатах поиска на новый.

Если адрес страницы временно меняется (например, если на сайте ведутся технические работы и все адреса нужно перенаправить на страницу с заглушкой), используйте редирект 302. В этом случае поисковая система перенаправит страницу из результатов поиска на новую страницу и не будет индексировать новую страницу.

Ситуации, когда вам нужно настроить 301 редирект:

- изменить домен;

- Перейти на другую CMS без сохранения старых адресов;

- Переключиться на защищенный протокол HTTPS;

- Изменить URL-адрес по техническим причинам (например, переместите все товары из категории /категория-1/ в /категория-2/);

- Вводить URL-адрес в формате ЧПУ («человеко-читаемый URL-адрес»);

Ситуации, в которых вам необходимо настроить переадресацию 302:

- В общем, мы рекомендуем вам не создавать ситуации, когда вам нужно настроить переадресацию 302; Однако, если URL-адрес меняется на период от 1 дня до 6 месяцев, настройте переадресацию 302.

Важный нюанс: при настройке редиректов будьте внимательны, чтобы не получить целую цепочку редиректов. Это ситуация, когда исходный URL-адрес перенаправляется на URL-адрес № 2, затем URL-адрес № 3 и так до бесконечности. Чтобы проверить, настроен ли редирект с сайта (и какие) и есть ли набор редиректов, воспользуйтесь уже упомянутым сервисом www.redirect-checker.org.

Избавьтесь от дублированного контента и метатегов

Дублирование страниц, контента и метатегов не допускается.

https://web-site2012.ru/media/posts/8/responsive/clearfy7_1-sm.webp 480w, https://web-site2012.ru/media/posts/8/responsive/clearfy7_1-md.webp 768w, https://web-site2012.ru/media/posts/8/responsive/clearfy7_1-lg.webp 1024w, https://web-site2012.ru/media/posts/8/responsive/clearfy7_1-xl.webp 1360w, https://web-site2012.ru/media/posts/8/responsive/clearfy7_1-2xl.webp 1600w" alt="Избавиться от дублей контента, мета-тегов" width="926" height="591" class="is-loaded" style="box-sizing: border-box; margin: 0px; padding: 0px; height: auto; max-width: 100%; vertical-align: top; border-radius: var(--border-radius); display: inline-block; opacity: 1; transition: opacity 1s cubic-bezier(0.215, 0.61, 0.355, 1) 0s;" loading="lazy" />

Двойник это плохо. Если у страницы сайта есть дубликат, то из индекса (и уж тем более из ТОПа) могут выйти оба: и дубликат, и оригинал. Если метатеги одинаковые на разных страницах, шансы снова выйти в ТОП равны нулю. Поэтому дубликаты должны быть отслежены и уничтожены без пощады.

Вот наиболее распространенные причины дублирования контента:

- Сайт доступен сразу по двум адресам - site.ru и www.site.ru.

- Сайт доступен сразу по двум протоколам - по http и по https.

- Каталоги и разделы доступны с завершающей косой чертой (/) или без нее.

- Главная страница site.ru открывается сразу по нескольким адресам — site.ru/index.html, site.ru/index.php, site.ru/index, site.ru/main/ и т.д.

- Сайт настроен и использует ЧПУ, но страница также доступна через параметрические URL-адреса.

- Сайт использует UTM-метки для отслеживания рекламных кампаний.

Чтобы противостоять атаке клонов:

- Правильно настроить «основное зеркало» сайта.

- Удалите все ненужные адреса технических страниц, случайно созданные при создании сайта.

- Избегайте параметрических URL-адресов, если NC уже настроены.

- При использовании тегов UTM сообщайте поисковым системам канонический адрес страницы.

Проще всего отрегулировать «главное зеркало», потому что: это только вопрос техники. Главное зеркало - это основной адрес сайта, например у нашего сайта главное зеркало https://web-site2012.ru: с протоколом https, без www и без слэша в конце. Соответственно, все остальные варианты адресов должны быть перенаправлены на этот мастер-адрес. Поисковики сами могут определить первичное зеркало, но это не всегда работает, особенно для крупных сайтов более 1000 страниц, и дубликаты попадают в индекс, снижая шансы на выход в ТОП. Подробнее о настройке зеркала главной страницы смотрите в официальной справке Яндекса.

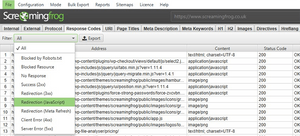

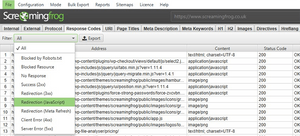

Удаление ненужных адресов технических страниц уже сложнее, т.к. они должны быть сначала обнаружены. Специализированное программное обеспечение, такое как Screaming Frog SEO Spider или его бесплатный аналог Xenu, отлично справляется с проверкой внутренней оптимизации веб-сайта на наличие дубликатов. Софтом находим все "оставшиеся" адреса и оставляем только один.

https://web-site2012.ru/media/posts/8/responsive/screamingfrog-2-sm.webp 480w, https://web-site2012.ru/media/posts/8/responsive/screamingfrog-2-md.webp 768w, https://web-site2012.ru/media/posts/8/responsive/screamingfrog-2-lg.webp 1024w, https://web-site2012.ru/media/posts/8/responsive/screamingfrog-2-xl.webp 1360w, https://web-site2012.ru/media/posts/8/responsive/screamingfrog-2-2xl.webp 1600w" alt="Скриншот Screaming Frog SEO Spider внутренняя оптимизация сайта" width="750" height="341" class="is-loaded" style="box-sizing: border-box; margin: 0px; padding: 0px; height: auto; max-width: 100%; vertical-align: top; border-radius: var(--border-radius); display: inline-block; opacity: 1; transition: opacity 1s cubic-bezier(0.215, 0.61, 0.355, 1) 0s;" loading="lazy" />

Если на вашем сайте используются параметрические URL-адреса, попробуйте заменить их ЧПУ -адресами (которые лучше индексируются). Если такой возможности нет (например, фильтр реализован в каталоге товаров), компромиссным решением является изготовление копий страниц, но в формате ЧПУ. Например https://www.site.ru/catalog/audio_and_digits/tv/AKAI/ - страница проиндексирована; а https://www.site.ru/catalog/audio_and_digits/tv/AKAI/?available=1&status=55395790&am.... не индексируется и поисковая система не заподозрит дублированный контент. Вторая страница не будет проиндексирована из-за директивы disallow: */? в robots.txt.

Аналогичная ситуация с UTM-метками. Например, стандартные UTM-метки, используемые в Яндекс.Директе, Яндекс уже сам распознает и не пытается добавлять их в индекс. но адреса с тегами UTM, используемые для других целей, могут быть перепутаны поисковой системой с самостоятельными страницами. Проблема также решается директивой Disallow в файле robots.txt.

Помимо дублированного контента, частой проблемой при оптимизации внутренних веб-сайтов являются повторяющиеся метатеги. Они появляются, когда метатеги заполняются автоматически, например. в каталогах товаров интернет-магазина. Дублирующиеся метатеги должны обрабатываться так же, как и дубли контента: специализированным программным обеспечением. И если они попадутся, останется только сделать их уникальными. Когда много дубликатов, работа непростая, т.к. ручная разметка свыше 1000 страниц, даже при высокой потребности в обновлении, слишком громоздка и затратна; Поэтому в таких случаях используется масочное наполнение. Например, если у вас есть магазин телевизоров и 50 телевизоров Samsung имеют одинаковое название на листах товаров "Телевизоры Samsung" (заголовок и h1 одинаковы на 50 разных страницах), вы должны переименовать их, вставив в заголовок разные параметры: ТВ -Тип, диагональ, цвет, того же сечения.

SEO оптимизация изображений

Если есть дубликаты, пустой Sitemap.xml, ошибка 404, которая не работает — это прямо «уголовка» в представлении поисковиков; то неоптимизированные изображения — это как административное правонарушение. Однако практика показывает, что оптимизация изображений дает общий «плюс в карму» и позиции поднимаются быстрее; и конечно, если изображения оптимизированы, вы можете использовать их для попадания в поиск картинок Яндекса и Google, что принесет дополнительный трафик по определенным темам.

5 советов по оптимизации изображений:

- Публиковать надо уникальное изображение;

- Используйте сервисы сжатия, чтобы уменьшить вес изображения в килобайтах (чем меньше вес, тем быстрее загружается изображение);

- Обязательно включите атрибуты alt и title, а также слова и фразы, относящиеся к изображению;

- Назовите файлы изображений в форме ЧПУ (аналогично URL-адресам - предпочтительна транскрипция);

- Используйте разметку schema.org для изображений от Яндекса и Google.

Наполнение сайта ключевыми словами

Когда сайт технически готов, пришло время насытить его семантикой, т.е. релевантные слова/фразы, которые вы будете использовать для их продвижения.

Семантический контрольный список:

- Большое и актуальное семантическое ядро;

- Уникальный, интересный и разнообразный контент;

- Правильно заполненные SEO-теги;

- Интеллектуальная . перелинковка ключевых слов.

Семантическое ядро сайта представляет собой упорядоченный набор слов, их морфологических форм и их выражений, наиболее точно характеризующих вид деятельности, товары или услуги, предлагаемые сайтом. Проще говоря, это набор фраз/слов, которые должны использоваться пользователями поисковых систем для поиска вашего веб-сайта.

Этот метод внутренней оптимизации состоит из четырех шагов:

- Ручной сбор ключевых слов с помощью специальных сервисов: Яндекс.Вордстат (подбор слов) и Google Adwords.

- Дополнить семантику ключевыми словами конкурентов (хороший выбор — SEMrush) и словами из готовых баз (например, База Пастухова).

- Удаление нецелевых и неэффективных слов из списка результатов.

- Кластеризация запросов. Подавать на странице следует группу запросов, направленных на решение конкретной задачи пользователя. Благодаря группировке получается карта распределения запросов на сайте.

Советы. Существуют платные сервисы, совмещающие в себе сразу несколько функций: работа с Яндекс.Вордстатом, базами данных, конкурентный анализ и т. д. Один из лучших таких сервисов — Key Collector.

Создавайте контент на основе семантики

https://web-site2012.ru/media/posts/8/responsive/semanticheskoe_yadro2-sm.webp 480w, https://web-site2012.ru/media/posts/8/responsive/semanticheskoe_yadro2-md.webp 768w, https://web-site2012.ru/media/posts/8/responsive/semanticheskoe_yadro2-lg.webp 1024w, https://web-site2012.ru/media/posts/8/responsive/semanticheskoe_yadro2-xl.webp 1360w, https://web-site2012.ru/media/posts/8/responsive/semanticheskoe_yadro2-2xl.webp 1600w" alt="Создавайте контент на основе семантики" width="731" height="699" class="is-loaded" style="box-sizing: border-box; margin: 0px; padding: 0px; height: auto; max-width: 100%; vertical-align: top; border-radius: var(--border-radius); display: inline-block; opacity: 1; transition: opacity 1s cubic-bezier(0.215, 0.61, 0.355, 1) 0s;" loading="lazy" />

Когда кластеризация готова, пришло время составить бриф для копирайтера.

В ТЗ автору нужно указать следующее:

- Требование вставлять заголовок h1;

- Количество вхождений в текст каждого из предусмотренных для страницы запросов (рассчитывается с помощью логики, здравого смысла и анализа текстов конкурирующих сайтов);

- Диапазон символов текста без пробелов (обычно для хорошей индексации диапазон должен быть более 1000 символов, кроме страниц товарных листов; диапазон текста также определяется здравым смыслом и конкурентным анализом);

- Источники информации для написания интересного контента.

Общие SEO-рекомендации по текстам, полученным как поисковыми системами, так и пользователями (для отправки вашему копирайтеру):

- Текст должен быть интересным, полно и четко отвечать на вопрос пользователя;

- Текст должен быть уникальным (уникальность проверяется спецслужбами);

- Текст должен иметь низкий уровень тошноты (также проверяется сервисами);

- Если текст превышает 1000 знаков, его следует разбавлять иллюстрациями и другим мультимедийным контентом;

- В тексте должна использоваться разметка: структурирование по абзацам, выделение заголовками, подзаголовками, маркированные списки и нумерованные списки.

Правильно заполнить SEO-теги (заголовок, h1-h6, описание, ключевые слова, strong)

Следующим важным шагом для факторов внутренней оптимизации, после выбора семантики и написания текстов, является публикация текстов с SEO-тегами (часто называемыми «мета-тегами»). Иногда хорошо заполненные SEO-теги влияют на скорость подъема страницы в ТОП-10 больше, чем оптимизированные тексты.

SEO-теги — это заголовок, «описание», «ключевые слова», заголовки h1-h3. Пользователь видит заголовок, h1-h3 и описание, ключевые слова фактически видны только поисковым роботам. При заполнении SEO-тегов задача состоит в том, чтобы максимально точно ввести ключевые слова, соблюдая все требования ПС и сохраняя при этом должный внешний вид SEO-тегов, видимых пользователю. Все теги SEO должны быть уникальными и не могут быть пустыми.

Основные требования к SEO-тегам:

- Тег <title></title>. Важно указать точное вхождение ключевого слова хотя бы один раз. Выберите для него самое важное ключевое слово для страницы. Ключевое слово должно быть в начале заголовка, если это возможно. Яндекс учитывает первые 15 слов заголовка, а Гугл — первые 12.

- Метатег <meta name="description" content="" />. Поисковые системы часто используют фрагмент текста с ключевым словом в качестве описания страницы. Но иногда содержимое <description> используется как выдержка. Допустимый вариант описания: один текст не длиннее 160 символов, с использованием точного вхождения ключевого слова. «Описание» должно состоять из нескольких предложений, описывающих содержание страницы. Допускаются рекламные слоганы, цифры, конкретные факты и призыв к действию. Если «описание» соответствует тегу заголовка, поисковая система его проигнорирует.

- Метатег <meta name="keywords" content="" />. Этот метатег является второстепенным для поисковых систем и используется скорее как вспомогательное слово. Если правильно его заполнять слишком утомительно или вообще невозможно, то «ключевые слова» лучше вообще опустить.

- Тег <h1></h1>. Здесь важно использовать основное ключевое слово, но содержимое <h1> не должно совпадать с <title>. Важно соблюдать иерархию заголовков: <h1>, затем <h2>, затем <h3> — и так далее.

- Теги <strong></strong>,<u></u>,<em></em> — отмечают текст на странице. Эти теги улучшают читаемость текста, но ими не следует злоупотреблять. Нельзя выделять ключевые слова, только визуально подчеркивать основные мысли текста.

Советы Для упрощения работы с SEO-тегами также рекомендуем использовать утилиту Screaming Frog SEO Spider, которая после анализа поможет выявить повторяющиеся, пустые и слишком длинные SEO-теги.

Заполнять эти метатеги вручную для крупных интернет-магазинов довольно сложно из-за большого количества страниц. Для этого процесс автоматизирован с помощью шаблонов масок. Например, с их помощью можно массово озаглавить тысячи страниц с товарами сайта и всех его разделов.

Настроить перелинковку

Линкование (от слова «link» — «ссылка») означает установление обратной связи между страницами сайта: с главной страницы сайта в меню идёт ссылка на страницу с контактной информацией, а значит, есть внутренняя связь между главной страницей и страницей контактной информации. Чем больше на сайте ссылок, ведущих на страницу, тем больший вес она будет иметь в глазах поисковых систем.

6 советов по организации внутреннего нетворкинга:

- Сделайте якоря уникальными и разнообразными.

- Используйте ключевые слова в анкорах.

- Не включайте более одной ссылки на 1000 символов контента.

- Выделяйте гиперссылки цветом (классика: синие ссылки и черный текст).

- С внутренней оптимизацией интернет-магазинов и крупных порталов, массовыми ссылками на похожие статьи/товары и т.д.

- Избегайте циклических ссылок — это ситуация, когда страница ссылается сама на себя.

Сделайте сайт удобным для пользователя

Вы разместили на своем сайте поисковые системы, вышли в ТОП по нужным поисковым запросам - теперь вам предстоит удовлетворить посетителя, дать ему не только актуальный ответ на его запрос, но и возможность комфортно пользоваться сайтом.

Контрольный список юзабилити:

- Интерфейс удобный, отзывчивый на бизнес-задачи;

- Интересный контент и мультимедиа;

- Скорость загрузки высокая;

- Сайт адаптирован для мобильных устройств;

- Учитываются факторы коммерческого ранжирования.

Улучшить удобство использования

Эргономика сайта (от англ. «usability» — «удобство использования») — это уровень юзабилити сайта, который позволяет пользователю легко и быстро находить нужную ему информацию.

Основные факторы юзабилити сайта:

- Содержание. Контент всегда стоит на первом месте, когда речь идет о качестве веб-сайта. Тексты должны быть интересными и полезными; Тематическая и приятная графика; Дизайн современный и привлекательный.

- Высокая скорость загрузки страниц. Чтобы узнать, что именно нужно сделать для ее увеличения, воспользуйтесь официальным инструментом Google — PageSpeed Insights.

- Адаптивность сайта ко всем возможным устройствам, с которых пользователи могут заходить на сайт - ПК, ноутбуки, планшеты, смартфоны. Пригодность сотового телефона также можно проверить с помощью официального инструмента Google — Cell Phone Friendly Test.

Юзабилити, конечно, идет рука об руку со всем, что может способствовать удобству восприятия информации: удобные формы обратной связи, формы заказа; качественный дизайн; удобная навигация и т.д. Так что делайте сайты для людей.

Усиление бизнес-факторов

Бизнес-факторы играют большую роль в SEO

https://web-site2012.ru/media/posts/8/responsive/vneshnyaya-optimizaciya-min-sm.webp 480w, https://web-site2012.ru/media/posts/8/responsive/vneshnyaya-optimizaciya-min-md.webp 768w, https://web-site2012.ru/media/posts/8/responsive/vneshnyaya-optimizaciya-min-lg.webp 1024w, https://web-site2012.ru/media/posts/8/responsive/vneshnyaya-optimizaciya-min-xl.webp 1360w, https://web-site2012.ru/media/posts/8/responsive/vneshnyaya-optimizaciya-min-2xl.webp 1600w" alt="" width="400" height="267" class="is-loaded" style="box-sizing: border-box; margin: 0px; padding: 0px; height: auto; max-width: 100%; vertical-align: top; border-radius: var(--border-radius); display: inline-block; opacity: 1; transition: opacity 1s cubic-bezier(0.215, 0.61, 0.355, 1) 0s;" loading="lazy" />

«Бизнес-факторы» в контексте SEO — это все элементы веб-сайта, которые сообщают поисковым системам, что: а) веб-сайт что-то продает; б) на сайте вся информация, важная для совершения покупки потребителем, представлена в полной, достоверной и удобной для восприятия форме.

Список бизнес-факторов:

- Несколько способов связи: телефон, электронная почта, скайп и т.д.

- Несколько телефонов и наличие номера 8-800;

- Контакты отдельных сотрудников + их фото;

- Проезд и путь до офиса;

- Схема на Яндекс.Картах/Google Maps;

- Живые аккаунты в социальных сетях, наполненные контентом;

- рейтинги пользователей;

- указание цены (скидки, бонусные баллы);

- Наличие на складе и информация о доставке;

- раздел «О компании»;

- Сертификаты, Награды, Сертификаты, Дипломы;

- миссия компании;

- банковские реквизиты;

- Несколько точек для самовывоза товаров;

- Несколько способов доставки и описание условий;

- возможность задать вопрос онлайн;

- Фотография живого аккаунт-менеджера;

- Мгновенный ответ онлайн-консультанта;

- Часто задаваемые вопросы (FAQ);

- услуга обратного звонка;

- раздел «Помощь»;

- Акции, распродажи, специальные предложения;

- Фильтруйте и сортируйте для быстрого поиска товаров/услуг.

-

Для выхода в ТОП-10 в коммерческих рубриках желательно, чтобы все эти элементы присутствовали на сайте.

Повысить CTR в результатах поиска

Чтобы все шаги, описанные выше, не оказались напрасными и чтобы поисковые системы вознаградили вас высококонверсионным органическим трафиком, вы должны обеспечить привлекательность своих сниппетов.

Сниппет — это фрагмент содержимого страницы, который отображается в результатах поиска. В сниппете всегда отображаются: заголовок страницы, адрес, краткое описание, фавикон; в сниппет могут быть включены и другие элементы: ссылки на другие популярные страницы сайта («быстрые ссылки»), контактная информация (адрес, номер телефона, время работы), цена товара/услуги, рейтинг товара/услуги и др..

Контрольный список по сниппетам:

- Реализация разметки схемы Schema.org;

- загруженный фавикон;

- Настраиваемые имена быстрых ссылок через Яндекс.Вебмастер и Google Search Console;

- Заголовки страниц <title> должны не только содержать ключевые слова, но и быть интересными;

- Сайт зарегистрирован в Яндекс.Справочнике ;

- сопутствующие товары и цены Яндекса;

- Подключен Яндекс.Маркет и Google Merchant Center.

Внедрение разметки Schema.org

Микроразметка — мощный инструмент, потому что ее можно использовать даже для включения информации о цене во фрагмент. Микротеги — это специальные теги/атрибуты, добавленные в код страницы, которые сообщают ботам PS, что определенный контент соответствует определенному типу объекта.

Микроразметка Schema.org может выделять следующую информацию для поисковых систем:

- Сведения о продукте: название, цена, валюта, единицы измерения, рейтинг продукта;

- Статья: название, главное изображение, дата выхода, рейтинг;

- Контактные данные: место доставки, время работы.

- Помимо обзоров, сайты с видео, фильмами, музыкой и т.д.

После применения микроразметки ПС будет отображать в сниппете страницы дополнительную информацию, которая поможет повысить CTR.

Используйте все приемы, чтобы увеличить CTR

Сниппеты не очень гибкие; но есть лайфхаки, помогающие настроить их для повышения CTR.

- Обязательно загрузите на сайт уникальный фавикон, который будет привлекать внимание.

- Добавьте хлебные крошки и убедитесь, что структура страницы понятна и логична. Хорошая структура, хлебные крошки и частые посещения помогают превратить отдельные страницы в быстрые ссылки, которые появляются прямо в сниппете:

После того, как поисковик присвоил сайту «Быстрые ссылки», можно настроить их вид в Яндекс.Вебмастер и Google Search Console.

Подробнее о том, что такое «быстрые ссылки» и как их выбирают поисковые системы, см. в Справке Яндекса и Справке Google.

- В заголовок <title></title> добавьте больше, чем просто ключевые слова; сделайте заголовки интересными. Заголовок призван «захватить» пользователя, он так же важен, как и заголовок объявления для контекстной рекламы.

- Добавьте сайт в Яндекс.Справочник . И укажите все адреса компании, чтобы получить расширенные выписки, в которых указан адрес организации.

- Подключайте сервис Яндекс товаров и цен, если у вас есть интернет-магазин или сайт услуг, где четко указаны цены. Это позволяет вам выделиться среди конкурентов в поисковой выдаче и увеличить CTR, особенно если у вас есть ценовое преимущество.

- Яндекс.Маркет и Google Merchant Center позволяют улучшать сниппеты интернет-магазина (воздействие на сниппет аналогично сервису Яндекса «Товары и цены»).

- Выписка при добавлении сайта в Яндекс товары и цены

Советы от SEO.RUОбратите внимание, что «Доставка: Москва» в сниппете формируется исходя из географии пользователя. Так, если запрос введен из другого города, в результатах будет показана информация для соответствующего населенного пункта, так как в нашем случае услуга предоставляется по всей России. Подключение к сервису есть в Яндекс.Вебмастере - https://webmaster.yandex.ru/site/info/market/

Вместо заключения: Чек-лист для внутренней SEO-оптимизации сайта

Довести сайт до технического совершенства

robots.txt кор